AAGIで出来ること

AAGIでは、具体的に以下のような使用用途があります。・PCの直接操作

・1つのジェスチャをキーやマウスのクリックに1対1に対応させて利用

・Alt,Shift,Ctrl+キーや、左クリック+キーなどの組合せが可能

・上記キー組合せの連続送付が可能(各種ショートカットキーへ対応)

・これらをアプリ毎に異なる設定ができ、アプリが切り替わる度にその設定が自動で切り替わる

・トラックボールやスイッチインタフェースなどの各種既存デバイスとの併用が可能

・走査型キーボード/マウス経由のPC操作

・Windownsに搭載されているオンスクリーンキーボード(OSK)、オペナビ、Hearty Ladder

・パットdeマウス(1Ch操作)

・家電操作

・Gesture Link(本システムと並行して開発している独自ソフト)の利用

・Nature Remo(市販学習リモコン)経由で赤外線リモコン機器を操作

・その他にも、赤外線リモコンを持つ機器であれば基本的に登録が可能

・ゲーム操作

・PCゲーム(Steamやオンラインゲームなど)やNintendo Switch、SONY PlayStation、Microsoft Xboxなどの専用機を操作可能

・PCゲームはそのまま利用可能

・専用機はインタフェース(Titan One)を使用することで利用可能、Nintendo Switch Proコントローラーとの併用も可能

・Flex Controller(テクノツール)を利用して既存デバイスとの併用も可能

多種多様な障害者にどのように対応するのか?

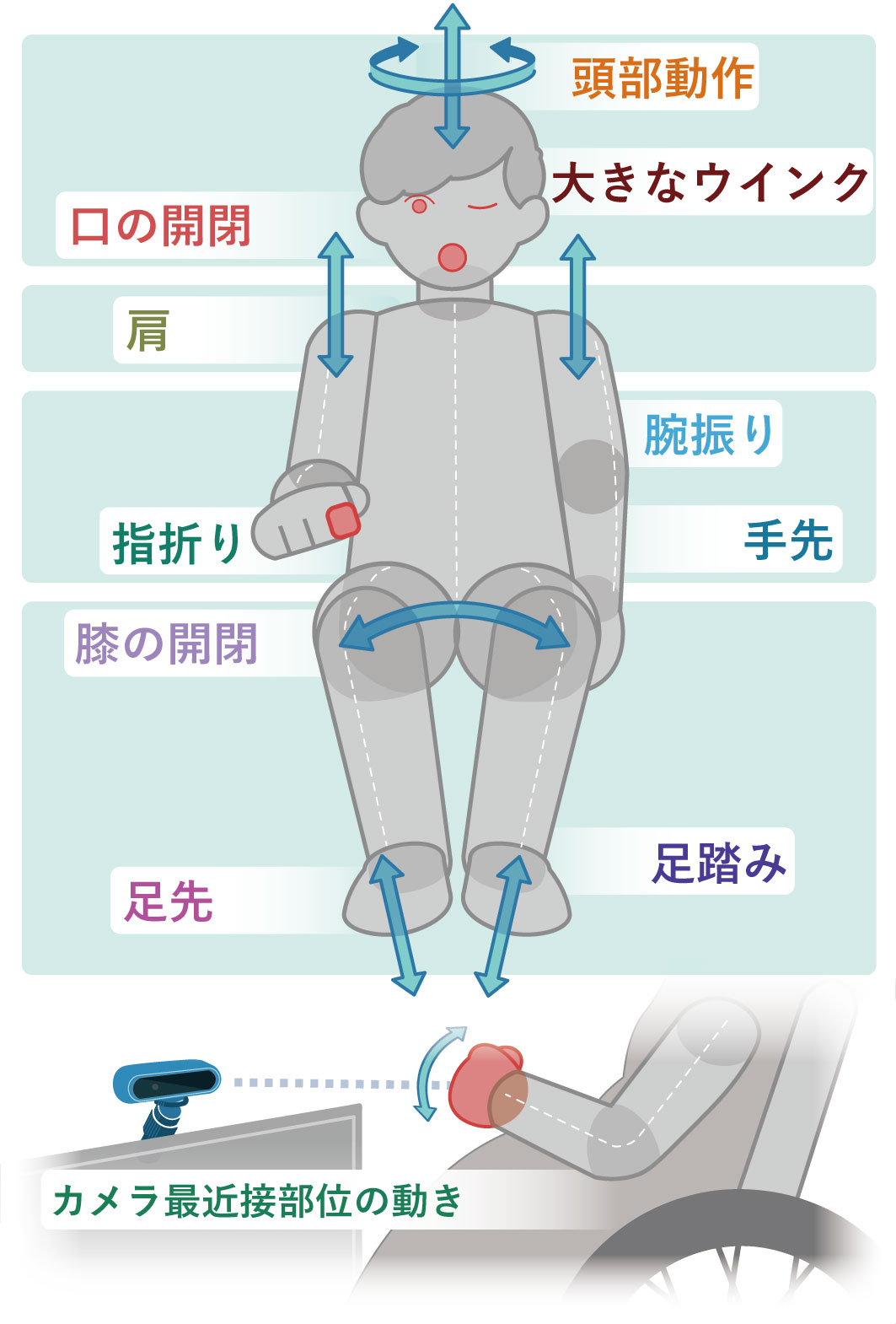

7年の歳月をかけて、各種距離カメラを利用して、表1に示すように対象となる運動機能障害者計81名、総計1745部位のジェスチャデータの収集を行いました。全ての障害者に対応することは不可能ですが、より多くの人に対応するため、実際のユーザがインタフェースとして望むジェスチャを収集しました。そして、部位別を基本に、手(3部位)、頭部(3部位)、足(3部位)、肩、未分類に分類しています。これは、可能な限り少ない認識エンジンで、多くの人に対応するためです。表1.収集されたジェスチャとその分類(2020年度末)

| 手・腕 | 指の折り曲げ | 299 |

| 手の動き | 80 | |

| 上腕の動き | 172 | |

| 頭部 | 頭部全体の動き | 401 |

| 口(口の開閉、舌の出し入れ) | 190 | |

| 目(流し目、ウィンク、目の見開き) | 252 | |

| 肩 | 肩の上下、肩の前後 | 121 |

| 脚部 | 膝の開閉 | 5 |

| 足踏み | 59 | |

| 足先の動き | 5 | |

| 上記以外 | - | 161 |

| 合計 | 部位総数 | 1745 |

| 総被験者数 | 81 |

マルチジェスチャ認識エンジン

表1の収集したジェスチャに基づき、これらを認識する9種の認識エンジンの基礎的な開発を行っています。データ収集をする障害者数に関しては、まだ充分とは言えませんが、本研究PJを開始した時点から、50~60名程度の実際のデータを集めることを目標としていました。これらを詳細に観察、分類しながら、表2に示すような複数の認識エンジンを開発しました。表2.ジェスチャ部位と認識モジュールの対応一覧

| 部位 | ジェスチャ | モジュール名 |

| 手・腕 | 指の折り曲げ | Finger |

| 手・上腕の振り | Front object | |

| 頭部 | 頭部の左右・上下の動き | Head |

| 両目を大きくつむる動き | Wink | |

| 口の開閉、舌の出し入れなどの口周りの動き | Tongue | |

| 肩 | 肩の上下・前後の動き | Shoulder |

| 脚部 | 足踏み | Foot |

| 膝の開閉 | Knee | |

| カメラ最近接部位の動き | Front object | |

| 全体 | 指定領域の微細な動き | Slight movement |

ジェスチャミュージック

ユーザは自分に適合する認識エンジンを選び、使用する認識エンジンによっては、一番最初に「GestureMusic」という音楽ゲームを行います。その中で、個人の部位の適合や、動かし方の適合をシステムが行います。そうすることで、システム側が、個人の動きを学習します。今までのキーボードやマウスは、個人がその使い方(空間的な動かし方)を覚えましたが、ジェスチャインタフェースは、システムがユーザの動きを覚えることができるのが特徴です。